當(dāng)前位置:首頁(yè) > 熱點(diǎn)資訊 > 內(nèi)容

時(shí)間:2024-04-25 11:55 來(lái)源:投資界 閱讀量:17062

蘋(píng)果公司突然公布了一則大新聞。

北京時(shí)間4月25日凌晨,蘋(píng)果在 Hugging Face 平臺(tái)上發(fā)布一個(gè)“具有開(kāi)源訓(xùn)練和推理框架的高效語(yǔ)言模型”,名為 OpenELM。

據(jù)了解,OpenELM有四種尺寸:2.7億、4.5億、11億和30億個(gè)參數(shù)版本,定位于超小規(guī)模模型,而微軟Phi-3模型為38億。這種小模型運(yùn)行成本更低,可在手機(jī)和筆記本電腦等設(shè)備上運(yùn)行。

同時(shí),在WWDC24開(kāi)發(fā)者大會(huì)之前,蘋(píng)果徹底開(kāi)源了OpenELM模型權(quán)重和推理代碼,數(shù)據(jù)集和訓(xùn)練日志等。而且,蘋(píng)果還開(kāi)源了神經(jīng)網(wǎng)絡(luò)庫(kù)CoreNet。

早在今年2月,蘋(píng)果公司CEO蒂姆·庫(kù)克就表示,蘋(píng)果生成式 AI 功能將于“今年晚些時(shí)候”推出,有消息稱即將在6月發(fā)布iOS 18可能是蘋(píng)果iOS史上“*”的更新,而9月也將推出*AI iPhone設(shè)備。

如今,蘋(píng)果似乎在新一輪AI浪潮快到尾聲的時(shí)刻追趕上了行業(yè)腳步。

1、預(yù)訓(xùn)練tokens數(shù)量減一半,11億參數(shù)蘋(píng)果模型效果卻比競(jìng)品更精準(zhǔn)

隨著ChatGPT風(fēng)靡全球,近幾個(gè)月來(lái),三星、谷歌、小米等手機(jī)廠商全面推進(jìn)大語(yǔ)言模型在手機(jī)、平板等端側(cè)上的使用,包括照片處理、文字處理增強(qiáng)等,并形成一大賣(mài)點(diǎn)。而蘋(píng)果很少透露并極少有類似的自帶功能,主要是用第三方工具做到類似效果。

今年2月財(cái)報(bào)會(huì)議上,庫(kù)克首次公布生成式 AI 計(jì)劃,并將在今年晚些時(shí)候?qū)?AI 技術(shù)集成到其軟件平臺(tái)中。

庫(kù)克表示,“我只想說(shuō),我認(rèn)為蘋(píng)果在生成式 AI 和 AI 方面存在著巨大的機(jī)會(huì),無(wú)需透露更多細(xì)節(jié),也無(wú)需超出自己的預(yù)期。展望未來(lái),我們將繼續(xù)投資于這些和其他將塑造未來(lái)的技術(shù)。其中包括 AI,我們繼續(xù)在 AI 領(lǐng)域花費(fèi)大量時(shí)間和精力,我們很高興能在今年晚些時(shí)候分享我們?cè)谠擃I(lǐng)域正在進(jìn)行的工作的細(xì)節(jié)。我們對(duì)此非常興奮。”

實(shí)際上,自年初至今,蘋(píng)果在生成式 AI 領(lǐng)域動(dòng)作不斷。今年3月,蘋(píng)果技術(shù)團(tuán)隊(duì)發(fā)表論文《MM1: Methods, Analysis amp; Insights from Multimodal LLM Pre-training》,首次披露蘋(píng)果大模型MM1,涵蓋300億參數(shù)、支持多模態(tài)、支持MoE架構(gòu),超半數(shù)作者屬于華人。

如今,針對(duì)手機(jī)、平板等端側(cè)領(lǐng)域,蘋(píng)果真正的開(kāi)源模型終于來(lái)了。

據(jù)論文顯示,蘋(píng)果開(kāi)源了大語(yǔ)言模型OpenELM,有指令微調(diào)和預(yù)訓(xùn)練兩種模型版本,共有2.7億、4.5億、11億和30億4種參數(shù),提供生成文本、代碼、翻譯、總結(jié)摘要等功能。

雖然最小的參數(shù)只有2.7億,但蘋(píng)果使用了包括RefinedWeb、去重的PILE、RedPajama的子集和Dolma v1.6的子集在內(nèi)的公共數(shù)據(jù)集,一共約1.8萬(wàn)億tokens數(shù)據(jù)進(jìn)行了預(yù)訓(xùn)練,這也是其能以小參數(shù)表現(xiàn)出*性能的主要原因之一。

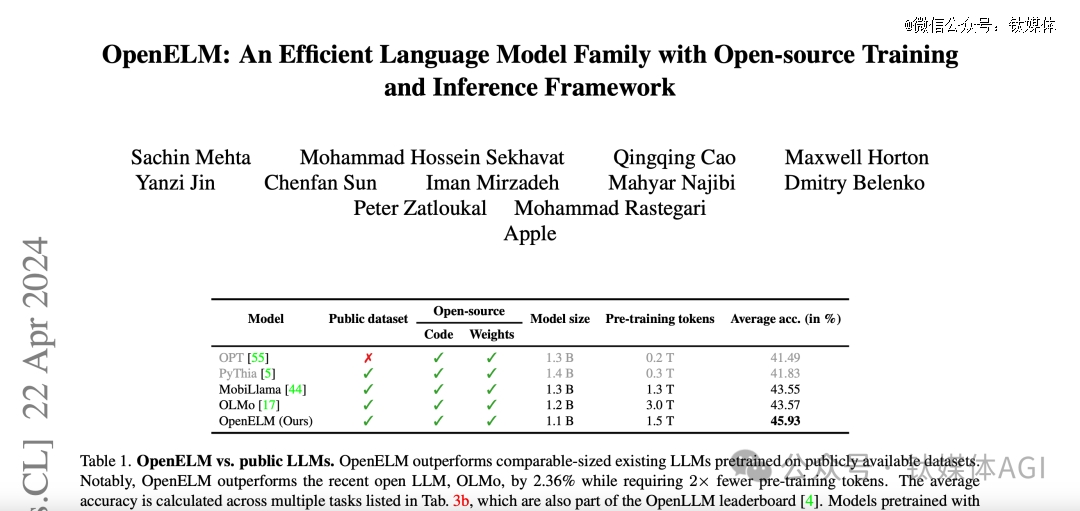

例如,11億參數(shù)的OpenELM,比12億參數(shù)的OLMo模型的準(zhǔn)確率高出2.36%,而使用的預(yù)訓(xùn)練數(shù)據(jù)卻只有OLMo的一半。

在訓(xùn)練流程中,蘋(píng)果采用了CoreNet作為訓(xùn)練框架,并使用了Adam優(yōu)化算法進(jìn)行了35萬(wàn)次迭代訓(xùn)練。而蘋(píng)果的MobileOne、CVNets、MobileViT、FastVit等知名研究都是基于CoreNet完成的。

蘋(píng)果在論文中還表示,與以往只提供模型權(quán)重和推理代碼并在私有數(shù)據(jù)集上進(jìn)行預(yù)訓(xùn)練的做法不同,蘋(píng)果發(fā)布的版本包含了在公開(kāi)數(shù)據(jù)集上訓(xùn)練和評(píng)估語(yǔ)言模型的完整框架,包括訓(xùn)練日志、多個(gè)檢查點(diǎn)和預(yù)訓(xùn)練配置。同時(shí),蘋(píng)果還發(fā)布將模型轉(zhuǎn)換為 MLX 庫(kù)的代碼,以便在蘋(píng)果設(shè)備上進(jìn)行推理和微調(diào)。

“此次全面發(fā)布旨在增強(qiáng)和鞏固開(kāi)放研究社區(qū),為未來(lái)的開(kāi)放研究工作鋪平道路。”蘋(píng)果研究團(tuán)隊(duì)表示。

此外,OpenELM不使用任何全連接層中的可學(xué)習(xí)偏置參數(shù),采用RMSNorm進(jìn)行預(yù)歸一化,并使用旋轉(zhuǎn)位置嵌入編碼位置信息。OpenELM還通過(guò)分組查詢注意力代替多頭注意力,用SwiGLU FFN替換了傳統(tǒng)的前饋網(wǎng)絡(luò),并使用了Flash注意力來(lái)計(jì)算縮放點(diǎn)積注意力,能以更少的資源來(lái)進(jìn)行訓(xùn)練和推理。同,蘋(píng)果使用了動(dòng)態(tài)分詞和數(shù)據(jù)過(guò)濾的方法,實(shí)現(xiàn)了實(shí)時(shí)過(guò)濾和分詞,從而簡(jiǎn)化了實(shí)驗(yàn)流程并提高了靈活性。還使用了與Meta的Llama相同的分詞器,以確保實(shí)驗(yàn)的一致性。

這次,蘋(píng)果很有誠(chéng)意將代碼開(kāi)源,一開(kāi)到底,把所有內(nèi)容都貢獻(xiàn)出來(lái)了。僅1天多的時(shí)間,該模型GitHub平臺(tái)上就獲得超過(guò)1100顆星。

而目前,大模型領(lǐng)域主要分為開(kāi)源和閉源兩大陣營(yíng),國(guó)內(nèi)外知名閉源的代表企業(yè)有OpenAI、Anthropic、谷歌、Midjourney、百度、出門(mén)問(wèn)問(wèn)等;開(kāi)源陣營(yíng)有Meta、微軟、谷歌、商湯、百川智能、零一萬(wàn)物等。

蘋(píng)果作為手機(jī)閉源領(lǐng)域的*,此次卻罕見(jiàn)地加入開(kāi)源大模型陣營(yíng)。有分析認(rèn)為,這可能在效仿谷歌的方式先通過(guò)開(kāi)源拉攏用戶,再用閉源產(chǎn)品去實(shí)現(xiàn)商業(yè)化營(yíng)利。

同時(shí),這也表明蘋(píng)果進(jìn)軍 AI 大模型領(lǐng)域的堅(jiān)定決心。

作為同為端側(cè)模型、開(kāi)源模型企業(yè),商湯科技聯(lián)合創(chuàng)始人、首席科學(xué)家王曉剛近期對(duì)鈦媒體App表示,開(kāi)源還是對(duì)于整個(gè)社區(qū)的發(fā)展還是非常重要的,是一個(gè)重要驅(qū)動(dòng)力。最終大模型的發(fā)展包括各種應(yīng)用,還是要整個(gè)社區(qū)共同去推動(dòng)的。對(duì)于大模型的應(yīng)用也分為不同的層次,這么多行業(yè)對(duì)應(yīng)用的需求也是不一樣的,豐富的開(kāi)源社區(qū)非常重要。

2、AI 技術(shù)持續(xù)“狂飆”,OpenAI獲得了全球*塊DGX H200

不止是蘋(píng)果,今天凌晨,國(guó)內(nèi)外 AI 技術(shù)依然“狂飆”,消息滿天飛。

今晨,OpenAI聯(lián)合創(chuàng)始人、COOGreg Brockman發(fā)推文表示,英偉達(dá)向該公司移交全球范圍內(nèi)*塊DGX H200,此舉旨在“推進(jìn)人工智能、計(jì)算技術(shù)與人類的發(fā)展”。

同時(shí),他也發(fā)布了一張合影,還包括英偉達(dá)CEO黃仁勛、OpenAI CEO奧爾特曼,看起來(lái)三人非常開(kāi)心。

早在2016年,OpenAI剛成立不久,黃仁勛便親自將全球首臺(tái)裝備了8塊英偉達(dá)P100芯片的超級(jí)計(jì)算機(jī)DGX-1送到了OpenAI的辦公室。

這臺(tái)價(jià)值逾百萬(wàn)美元的DGX-1,是黃仁勛帶領(lǐng)英偉達(dá)3000名員工,歷時(shí)三年精心打造的成果。它極大地提升了OpenAI的計(jì)算能力,將原本需要一年的訓(xùn)練時(shí)間縮短至僅一個(gè)月。

當(dāng)時(shí),OpenAI還處于一個(gè)初創(chuàng)階段的非營(yíng)利機(jī)構(gòu),這臺(tái)超級(jí)計(jì)算機(jī)無(wú)疑是一份*分量的禮物。馬斯克、Sam Altman以及其他早期員工對(duì)此感到無(wú)比激動(dòng),紛紛在這臺(tái)DGX-1上留下了自己的簽名。

2023年11月13日,英偉達(dá)發(fā)布了新一代AI GPU——NVIDIA Grace Hopper H200超級(jí)芯片,其內(nèi)存容量和帶寬分別是H100的兩倍和1.4倍,最高支持19.5TB,AI 性能達(dá)128 petaFLOPS FP8,預(yù)計(jì)2024年第二季度開(kāi)始供貨。

黃仁勛稱,這是擁有萬(wàn)億規(guī)模的新型 AI 超級(jí)計(jì)算機(jī),為巨型 AI 模型提供具有線性可擴(kuò)展性的海量共享內(nèi)存空間,能夠在生成式 AI 時(shí)代發(fā)揮巨大潛力。

如今,黃仁勛親手將全球*塊DGX H200送給了OpenAI。

同時(shí),據(jù)CTech報(bào)道,英偉達(dá)以約7億美元收購(gòu)了以色列AI基礎(chǔ)設(shè)施編排和管理服務(wù)Run:ai,據(jù)悉,Run:ai成立于2018 年,迄今已籌集1.18億美元,同時(shí)英偉達(dá)還收購(gòu)了Deci公司。

另外,今天凌晨,擁有全球* AI 代碼工程師的背后企業(yè)Cognition被曝完成了一輪1.75億美元的融資,由Founders Fund 領(lǐng)投,僅僅一個(gè)月內(nèi),公司估值從3.5億美元增長(zhǎng)到20億美元,引發(fā)關(guān)注。

Gartner分析師John-David Lovelock表示,隨著Anthropic、OpenAI 等*梯隊(duì)的玩家占據(jù)主導(dǎo)地位,AI投資范圍正在“向外延展”。

“數(shù)十億美元的投資數(shù)量已經(jīng)放緩,而且?guī)缀跻呀?jīng)結(jié)束;熱錢(qián)涌向了新方向——AI 應(yīng)用。”上述分析師表示,“大模型需要大量投資,但市場(chǎng)現(xiàn)在更多地受到科技公司的影響,這些公司將利用現(xiàn)有的 AI 產(chǎn)品、服務(wù)和產(chǎn)品來(lái)構(gòu)建新產(chǎn)品。”

Greylock合伙人Seth Rosenberg認(rèn)為,人們對(duì)于資助AI領(lǐng)域的“大批新玩家”的興趣本來(lái)就較很小。在這個(gè)周期的早期階段,投資基礎(chǔ)模型資本非常密集,相比之下,AI 應(yīng)用和智能體所需的資本較低,這可能是*美元融資額下降的原因。

Thomvest Ventures 董事總經(jīng)理 Umesh Padval 將 AI整體投資的縮減,歸因于增長(zhǎng)低于預(yù)期。他表示,最初的熱情已經(jīng)讓位于現(xiàn)實(shí)—— AI 面臨一部分技術(shù)挑戰(zhàn),一部分上市挑戰(zhàn),可能需要數(shù)年時(shí)間才能解決并完全克服。

”AI 投資放緩反映出人們認(rèn)識(shí)到,我們?nèi)栽谔剿?AI 技術(shù)發(fā)展及其在各行業(yè)應(yīng)用的早期階段。雖然長(zhǎng)期市場(chǎng)潛力仍然巨大,但最初的熱情已被在實(shí)際應(yīng)用中推廣 AI 技術(shù)的復(fù)雜性和挑戰(zhàn)所削弱……這表明投資環(huán)境更加成熟和敏銳。“Umesh Padval表示。

如今,AI 持續(xù)“狂飆”,但整個(gè)市場(chǎng)方向已快速轉(zhuǎn)變,端側(cè)模型、AI 應(yīng)用、行業(yè)大模型等都將成為今年整個(gè) AI 領(lǐng)域新趨勢(shì)。

聲明:免責(zé)聲明:此文內(nèi)容為本網(wǎng)站轉(zhuǎn)載企業(yè)宣傳資訊,僅代表作者個(gè)人觀點(diǎn),與本網(wǎng)無(wú)關(guān)。僅供讀者參考,并請(qǐng)自行核實(shí)相關(guān)內(nèi)容。